はじめに

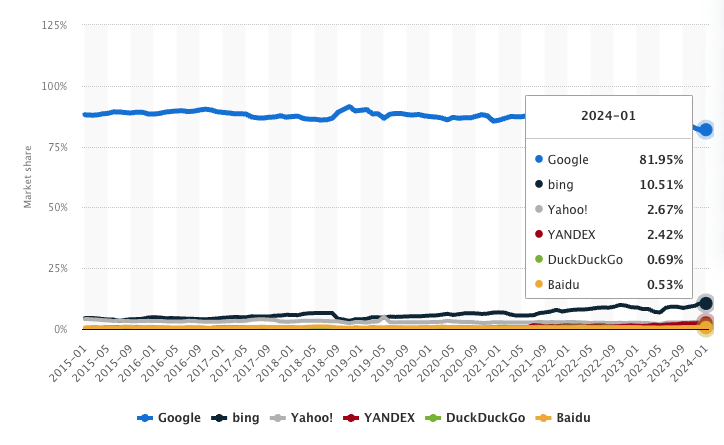

2024年2月19日にガートナー社は、2026年までにAIチャットボットやバーチャルAIアシスタントなどの台頭により検索エンジンボリュームが25%も減少するという調査結果を発表した。

検索エンジンは依然としてGoogleの牙城ではあるが、MicrosoftのBingが台頭してきており、ここ5年くらいでGoogleのシェアは90%から80%近くにまで落ちてきている。

この記事では、仮にAI検索時代となった時に、SEO対策にどのような影響が出るか、コンテンツ評価の基準はどう変わるかについて記載する。

AIチャット検索とは

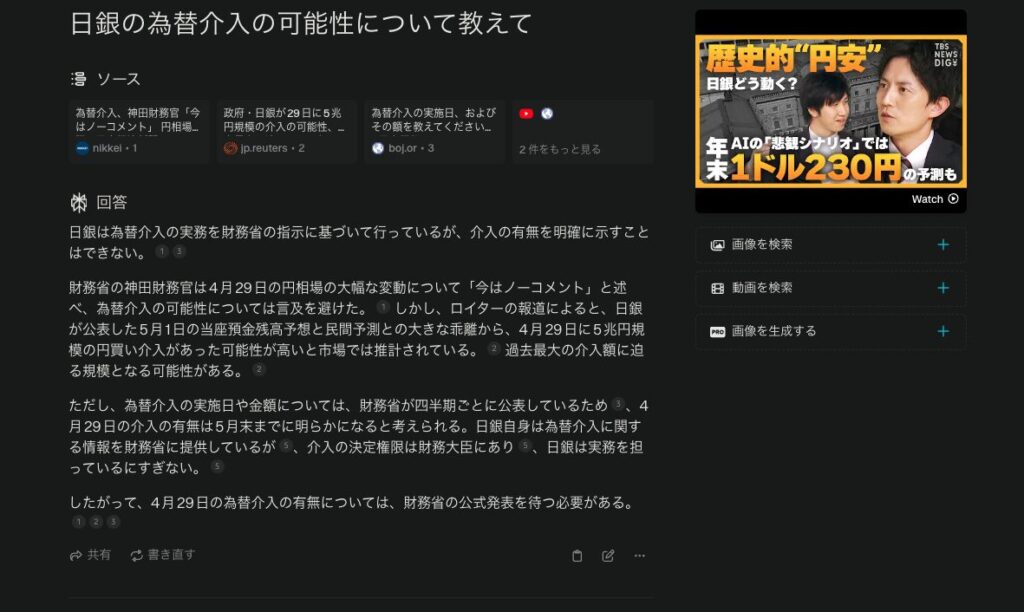

例えば、Perplexity というAIチャットボットは、チャット形式でさまざまな情報を検索できる大規模言語モデルをベースとする「回答エンジン」を提供している。Perplexityは、回答を生成する際に、必ずどのウェブページの情報を参照したのか引用リンクを付ける。

試しに、タイムリーな内容として「日銀の為替介入の可能性について教えて」と質問したところ下記の回答が表示された。

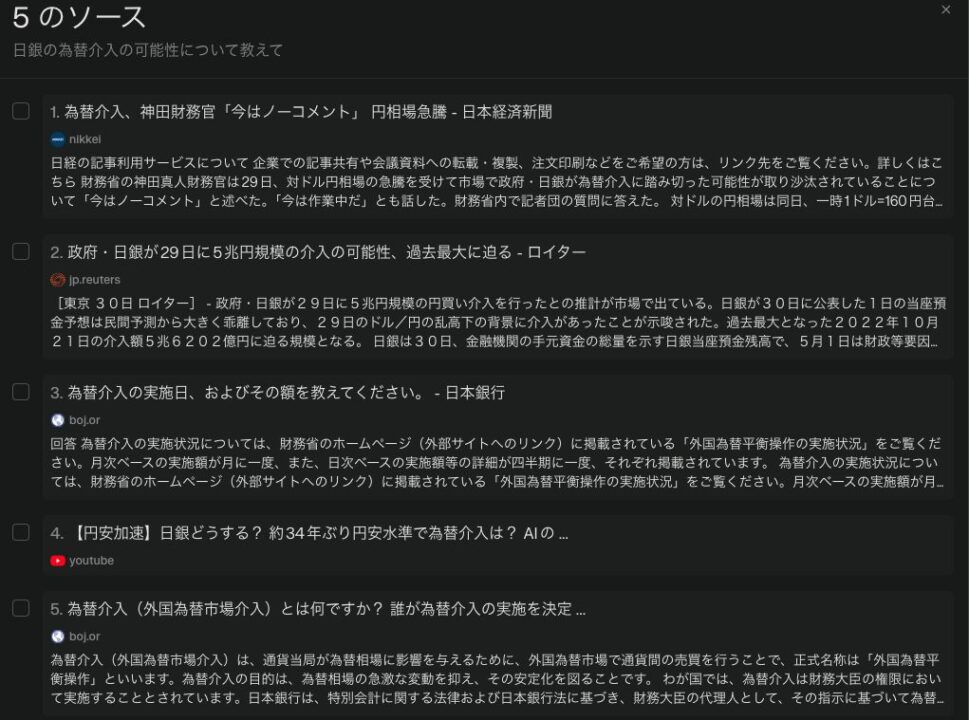

ソースとして5件、日経やロイター、youtubeなどが表示されている。

回答の文章の末尾に、引用番号という形でソースが添えられている。論文を読むときの参考文献と似たような感じだ。

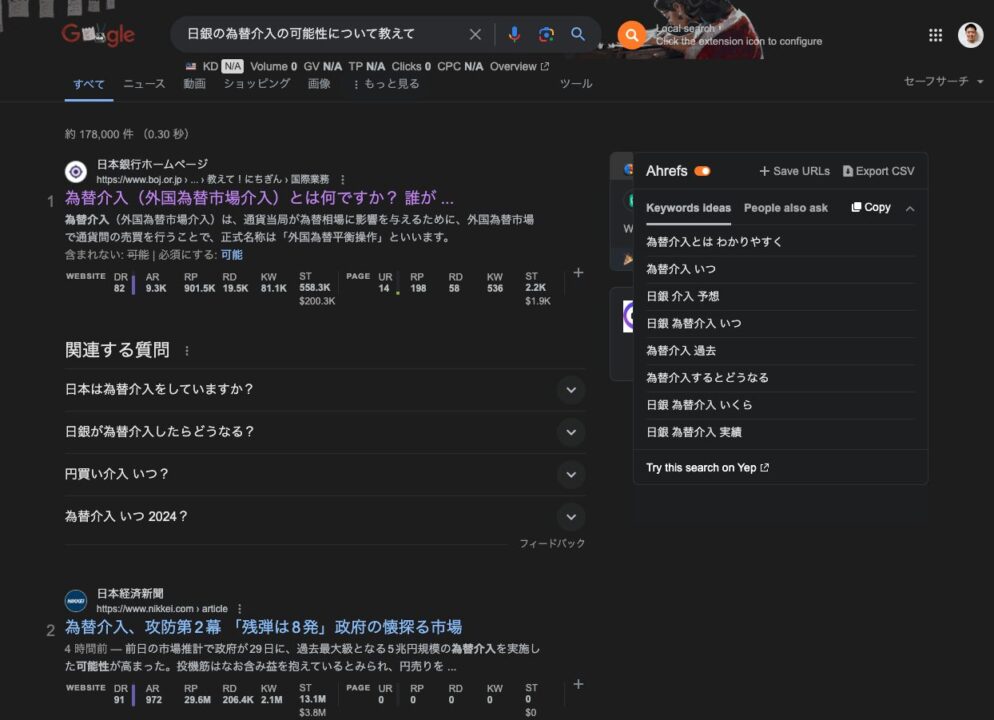

一方、Googleの場合はこちら。1位の日銀のサイトは、日銀の為替介入に関する一般的な説明が表示されているが、ここには今回の「日銀の為替介入の可能性」に関する記載はない。検索の文章から該当キーワード(日銀・為替介入)を抽出して、キーワードマッピングを行なったことによる(つまり文脈理解による検索結果ではない)ものだろう。

一方で、Perplexityの場合、同様の日銀のサイトは1位ではなく5番目のソースとして表示されている。

というわけで、ユーザーがGoogle検索からAIチャット検索に移行するようになると、回答の引用として表示されるおよそ5件くらいのリストに自社コンテンツが入るかどうかの戦いになる。

Google検索の場合は1ページ、つまり上位10件に入るかどうかの戦いだったが、枠はさらに厳しくなると予想される。

ちなみに、googleのGemini AIもAHチャット検索で引用を表示しているが、4-5件である。

SEO対策の変化:よりコンテンツの質を評価

先ほどのGardener社のレポートにも記載されているが、

生成AIがコンテンツ制作のコストを下げることで、キーワード戦略やウェブサイトのドメインオーソリティのスコアリングなどの活動に影響が出る。検索エンジンのアルゴリズムは、膨大な量のAIが生成したコンテンツを相殺するために、コンテンツの質をさらに重視するようになるだろう。

出典:https://www.gartner.com/en/newsroom/press-releases/2024-02-19-gartner-predicts-search-engine-volume-will-drop-25-percent-by-2026-due-to-ai-chatbots-and-other-virtual-agents

とのこと。Googleは今までSEO業社との戦いで、よりコンテンツの質を評価するように進化してきた。具体的には、metaキーワードや記事内にキーワードを散りばめるキーワードスタッフィングなどは、もはや有効ではなくなってきている。

しかし、いまだに、タイトルやmetaディスクリプション、被リンクなどは有効とされており、コンテンツの質の評価という観点では改善の余地がある。

生成AIでコンテンツ生成のコストが格段に下がる一方、信ぴょう性が怪しかったり、似たような内容のコンテンツで溢れかえることが予測されるので、より出典の信頼性があり、コンテンツとして差別化されている内容が評価されるようになるだろう。これは、Googleの検索エンジンも生成AIコンテンツ対策として行うし、PerplexityのようなAIチャット検索サービスはもちろん、LLMの内在する仕組みとして生成AIコンテンツ対策を行うだろう。

より具体的に、コンテンツ評価の基準について見ていく。

AIによるコンテンツ評価の基準

- 正確性: コンテンツが事実に基づいているかどうかが重要。誤情報や偽情報は排除され、正確で検証された情報のみが引用されることが求められるる。

- 信頼性: 出典の信頼性が重要であり、科学的研究や公的機関、認知度の高い専門家によるコンテンツが好まれる。

- タイムリネス: 情報の新しさもまた重要。特に急速に変化するトピックにおいては、最新の情報が優先される傾向にある。

- 包括性: ユーザーの質問に対して多角的に回答するために、異なる視点を提供するコンテンツが評価される。LLMの学習的にも異なるデータを食わせた方が良いので、そのような独自性のあるコンテンツはより評価されるだろう。

- 関連性:ユーザーの質問やトピックに最も関連性が高い情報を選択する。

この「関連性」について、より詳しく見ていく。

Google検索とLLMにおける関連記事の抽出の違い

Google検索エンジンのアルゴリズム

キーワードマッチング:

Google検索では、ユーザーが入力したキーワードがウェブページのどこに、どのように使われているかを中心に評価する。ページ内でのキーワードの出現頻度(頻度、密度)、タイトルタグやメタデータでの使用などが重要視される。

リンク構造分析:

ページランクアルゴリズムを用いて、ウェブページが他のページからどれだけリンクされているかを評価する。多くの高品質なサイトからリンクされているページは、より信頼性が高く関連性があると見なされる。

ユーザー行動の分析:

クリック率(CTR)など、過去のユーザー行動を分析し、どのページが実際にユーザーのニーズに応えているかを評価する。

Transformerを用いた大規模言語モデル(LLM)

LLMを理解するには、元となるTransformerという深層学習のモデルとAttention機構について理解する必要がある。下記動画が分かりやすい。

Transformerの登場により、関連性という観点で下記の大きな変化があった。

文脈理解に基づく関連性評価:

Transformerは自己注意機構を使用して、入力されたテキスト全体の文脈を理解する。これにより、単純なキーワードのマッチングを超え、文の意味やニュアンスを捉えることができる。

セマンティックマッチング:

キーワードが直接一致しなくても、文脈や意味が似ているフレーズやテーマを特定して関連性を判断する。これにより、より深いレベルでのテキスト理解が可能になる。

動的な学習と適応:

LLMは継続的にトレーニングデータから学習を行い、新しい言語パターンや表現に適応する能力を持つ。これにより、時間とともにその評価の精度を向上させることが可能。Google検索のようにアルゴリズムのアップデートが定期的に行われて、その度に大幅に検索順位が変動するという離散的な変化から、より動的な学習に基づく連続的な検索順位の変動になるだろう。

Google時代との違い

まとめると、Google時代との違いとして下記が挙げられる。

- SEOのキーワード戦略の変化: Google検索ではキーワード最適化が重要だったが、AIチャット検索では文脈理解がさらに強調され、キーワードに依存しない自然言語処理能力が求められる。

- リンクの重要性の低下: 従来のSEOでは、他サイトからのリンクがランキング向上に寄与したが、AI検索ではコンテンツの質自体がより直接的に評価されるため、リンクの数よりもコンテンツの質が重要視される。

AIチャット検索になると、ユーザーは「日銀 為替介入」のようなキーワードをリストアップする検索ではなく「日銀の為替介入の可能性は?」といった文章で検索(質問)をするようになる。

そして、google時代では、ユーザーがキーワード検索入力だったので、キーワードの頻度マッチングなどが主流だったが、AIチャット検索時代では、ユーザーの自然言語的な検索から、より、その文脈に適合したコンテンツが選ばれるようになる。

より、権威性・専門性の高い人や機関が記載した、誤情報のないコンテンツで、かつ最新情報に対応しており、ユーザーの自然言語的な(文章的な)質問にマッチするコンテンツを提供することが求められるようになる。

ユーザーの検索(質問)ニーズにあった回答を用意しましょうねという身も蓋もない当たり前の話に帰結するのだが。。。

そして、小手先のSEO対策は、よりしづらくなる。

コメント