2023年9月29日に、OpenAIが発表したGPT-4Vの論文「The Dawn of LMMs: Preliminary Explorations with GPT-4V(ision)」。発表からすでに2ヶ月半が経ち、ブーム去った感もなきにしもあらずだが、今回論文読んだので備忘録的にまとめ。

全部で166ページもあり多かったが、写真付きのプロンプトの事例が半分以上を占めていたので、非常にわかりやすかったし、読みやすかった。

LLMsからLMMsへ

今まではテキスト情報だけを入力値として扱う、大規模言語モデル(LLMs:Large language models)だったが、GPT-4Vははテキスト情報以外のマルチモーダル(画像、サブ画像、テキスト、シーンテキスト、視覚ポインターなど)を扱えるようになった(LMMs:Large multimodal moderls)。

GPT-4VのVは、visionのことを指し、画像などの視覚情報も扱えるようになったことを指す。論文にも「GPT-4V(ision)」と記載があった。

GPT-4Vがサポートする入力情報

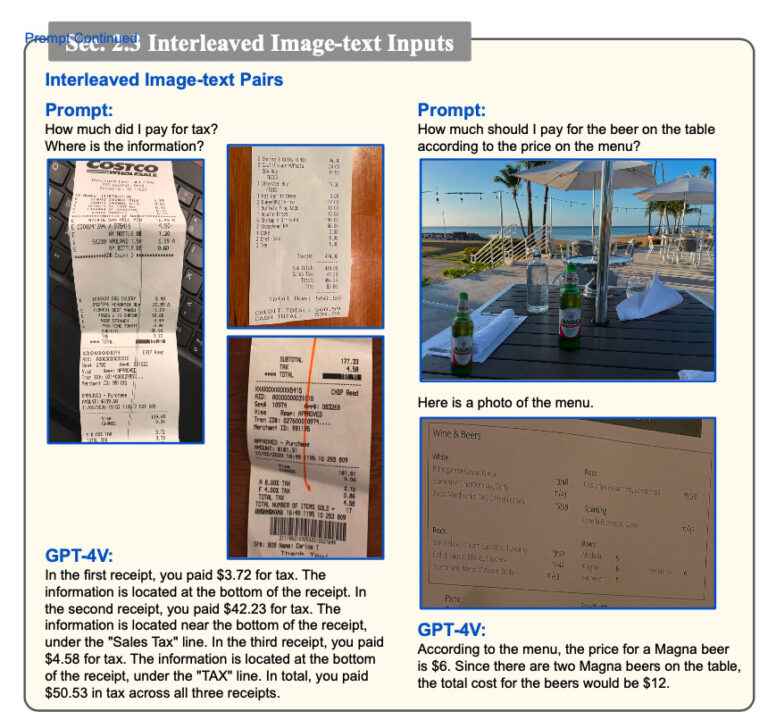

複数の画像とテキスト情報を組み合わせて処理できる(Interleaved Image-text Pairs)

複数の画像を一気に読み込ませることもできるし、テキスト-画像-テキスト-画像のように交互にプロンプトを入力しても、処理できるようになった。

Following Text Instructions

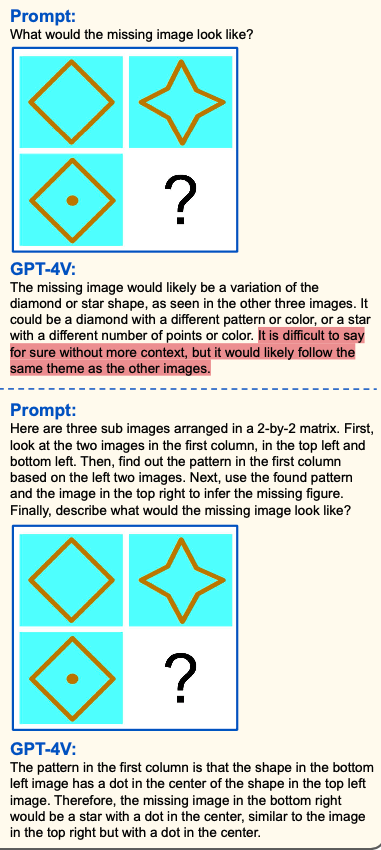

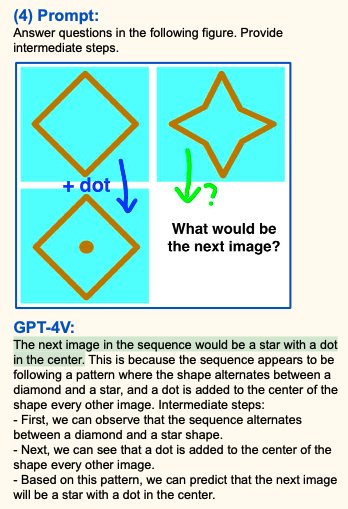

視覚情報だけを与えて、自動的にパターン認識して、答えを出すのはまだ難しそう。ただし、詳細なプロンプトを与えれば回答することができる。

下記例では、曖昧な質問だと「星の中にドット」というパターン認識からの回答(よく就活の筆記試験とかであるやつ)はできていない。正確には、さまざまなパターンを考えすぎてしまっていて、正解を1つに絞り込めていない。

ただし、こちらに関しては、わざわざテキストで詳細なプロンプトを入力するのは直感的ではないし手間である。後述するVisual referring promptingを使えば、下記のような手書き指示を組み合わせることで正解を得ることができる。

どのようなプロンプトを与えるのが効果的か、論文では「Constrained prompting」と「Condition on good performance」の2つが挙げられていた。

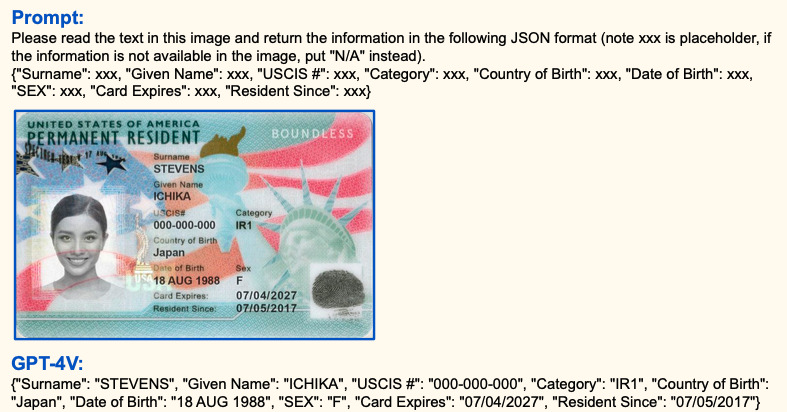

制約付きプロンプティング(Constrained prompting)

例えば、特定のJSONフォーマットでテキストを返すようにGPT-4Vに指示するなど。ここでは、パスポートの画像から、抽出したいデータをjson形式のkeyとしてプロンプト指示の中に与える(Condition)ことで、対応するvalueを自動的に抽出している。

良好なパフォーマンスへの条件付け(Condition on good performance)

プロンプト例:You are an expert in counting things in the image. Let’s count the number of apples in the image below row by row to be sure we have the right answer.

段階的に考えてください(think step by step)だけではなく、プロンプトの最初に「専門家としての役割を仮定」させ、かつ、「成功するように」という明示的な指示を付け加えることで回答精度が上がるとのこと。へえーという感じだが。

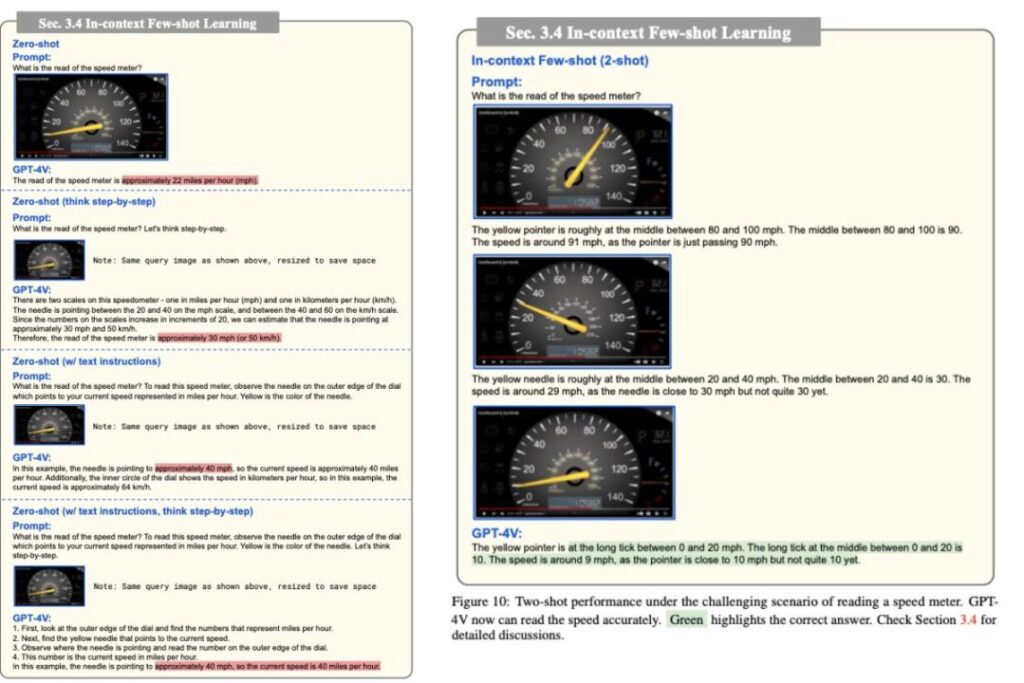

少数の事例をモデルに提示:In-context Few-shot Learning

これは、先の2つのプロンプトチューニングに当てはまるとも、当てはまらないとも言えないが、少数の事例をモデルに提示すると回答精度良くなるよという例。

下の自動車のメーターを画像から読み取る課題に関しては、入力する画像情報の事例が0の場合(Zero-shotという)は、いくらプロンプトを頑張っても正解は出せていない。しかし、事例を2,3プロンプトに含める(Few-shotという)ことで、正解を出した。

これは、finetuningとやっていることは同じであり、モデルの微調整として有効な代替案。

その他、精度の高い回答を得るためのプロンプトの工夫はこちら

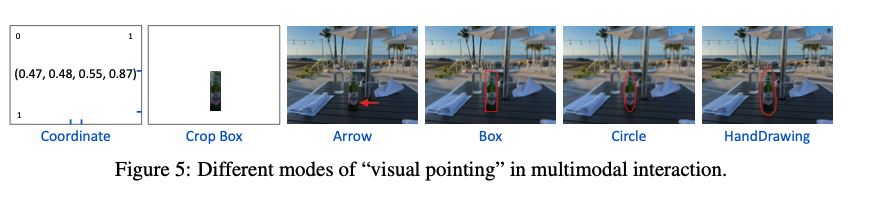

画像だけではなく注釈にも対応:Visual Referring Prompting

単に画像情報を読むだけではなく、画像の上に、人間が手書きで書いたポインターや囲み線なども処理できる。

画像上の特定の場所を指し示す方法として、座標を提供するか、画像を切り抜くか、直接画像に書き込むかを比較した結果、画像に直接書き込むことが最も精度高かったとのこと。なので、人間の直感的な指定の仕方(画像に目的の物体を上から手書きでアノテーションする)に最も合っている。

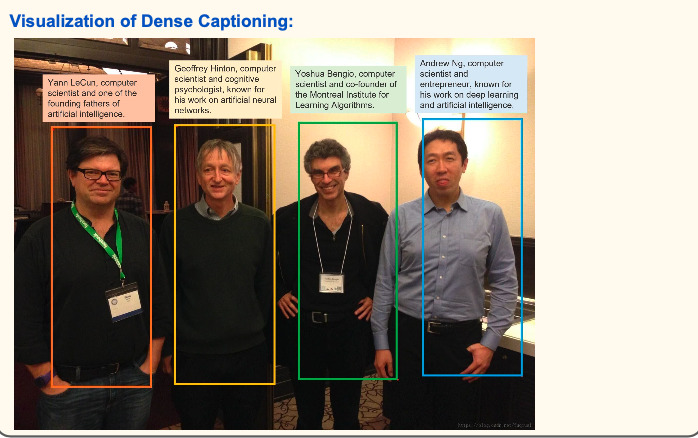

Dense captioning

画像内の複数の物体やシーンを認識し(物体検出)、それぞれに対して詳細な説明文を生成(画像説明文)するプロセス。

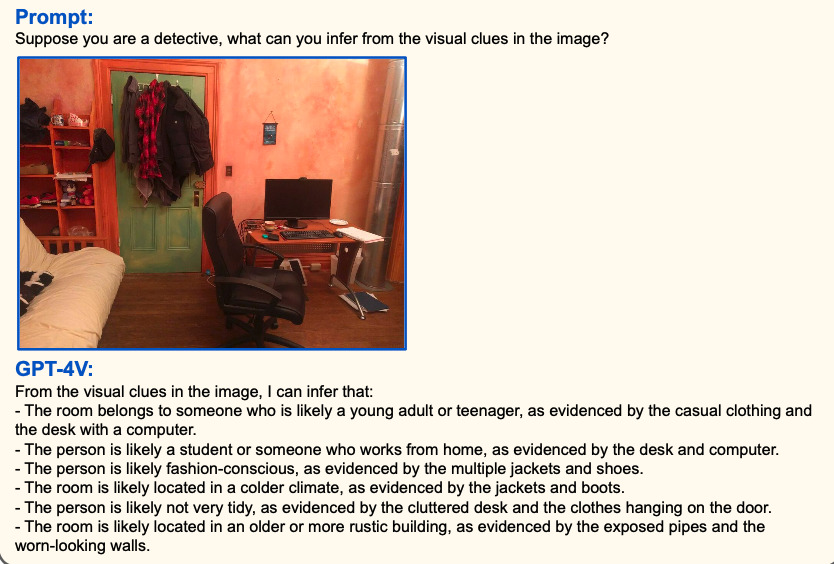

Multimodal Commonsense

多様な視覚的手がかりから複雑な推論を行う能力を獲得。

画像を与えて、シャーロックホームズのような推理をすることも可能。部屋や服の情報から、その人の身なりや職業などを推測している。これはすごい。

他にも、文化背景に基づくジョークやミームも理解。

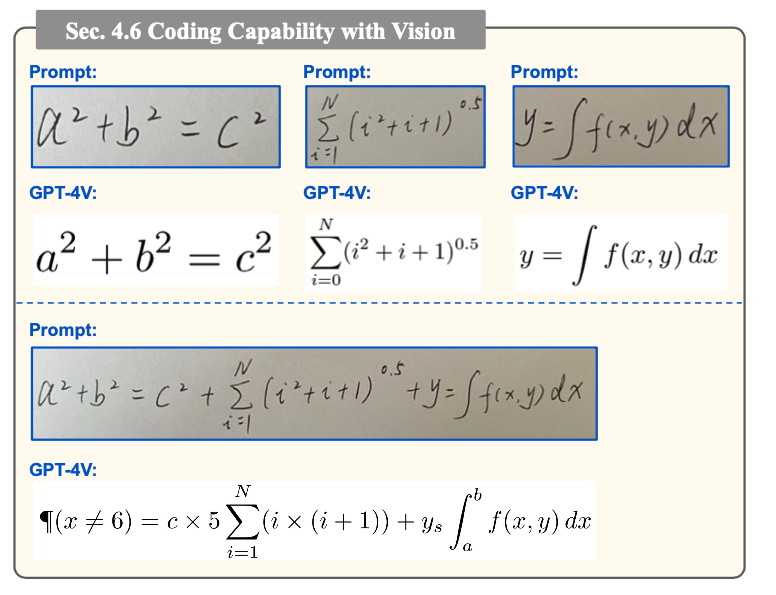

手書き文字認識に対応

GPT-4V活用事例

さまざまな産業分野での活用例が記載されていたが、自分が興味持った事例をいくつかピックアップ

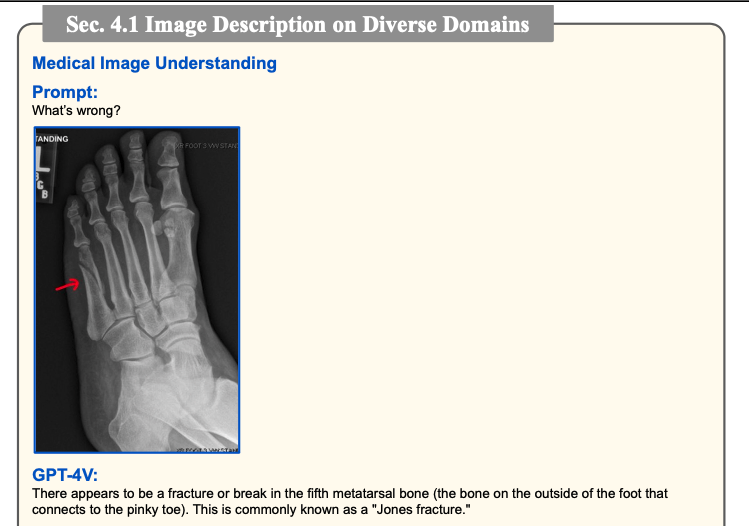

放射線画像診断:自動レポート生成

下記、医療画像の例では、足のレントゲンに注釈を添える(visual referring prompting)と、Jones骨折(第5中足骨疲労骨折)骨折かもしれないと場所まで添えて回答している。

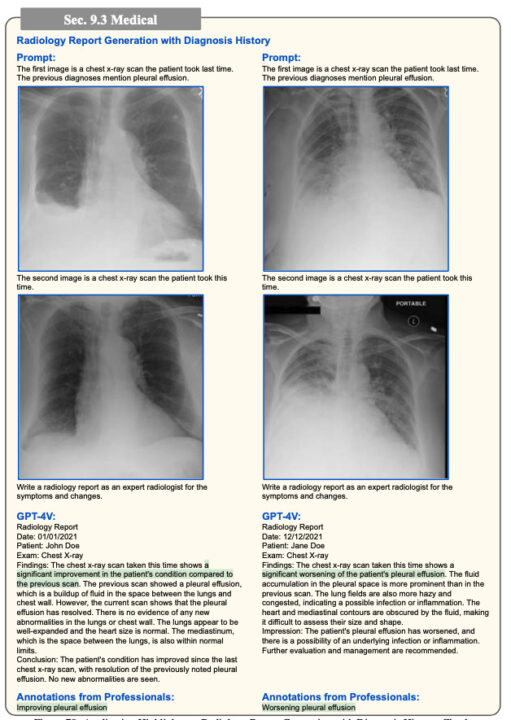

胸部CT画像に関しては

「多領域にわたってコンソリデーションとGGOを認めるので、肺炎か何かしらの炎症を示している可能性がある。右上葉に腫瘤または結節の可能性もある。」と回答している。

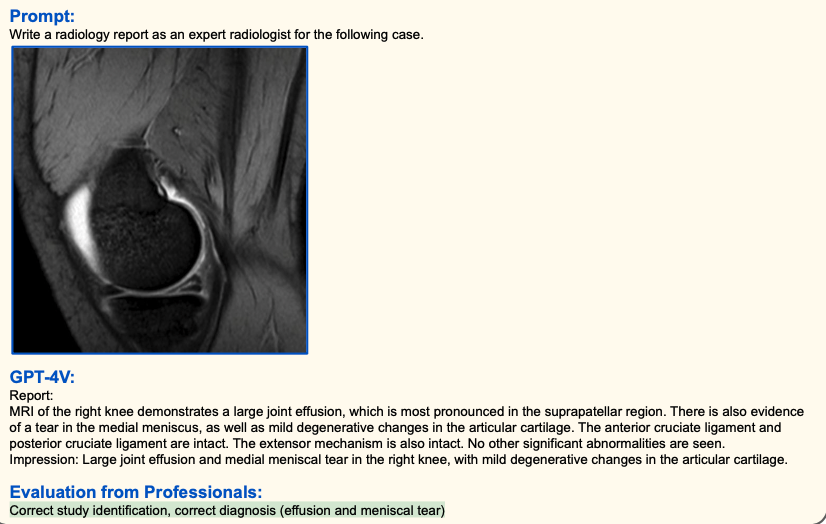

放射線診断レポートの自動生成にも使うことができる。先ほどの、Condition on good performanceのプロンプトテクニックを使って、「あなたは放射線診断専門医です。下記の画像の診断レポートを書いて」とプロンプトを指示して画像を貼り付けると、診断レポート生成してくれる。

時系列経過の評価も可能。過去の診療録データをプロンプトの入力として組み合わせると精度が高くなる(人間と一緒)。

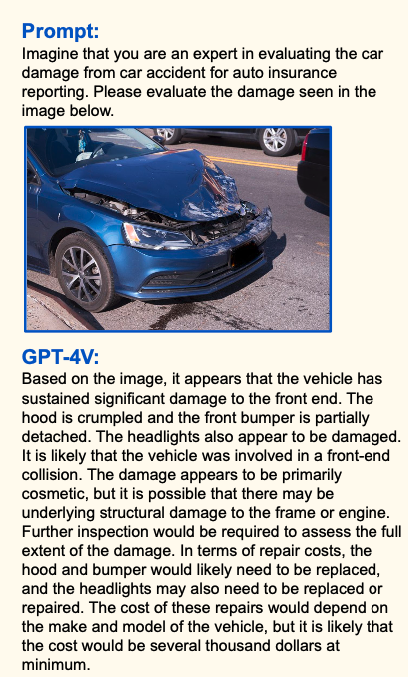

保険:損害の修理費用の自動見積もりとレポート生成

下記の車損傷の画像をもとに、損傷箇所と損傷程度について詳細に説明し、レポートを作成するとともに、修繕費用の見積額まで提示できる。これはかなり実用的。

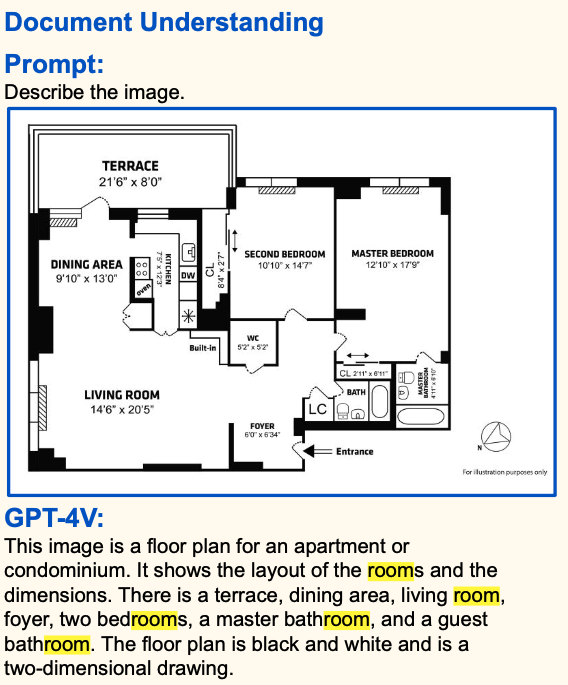

不動産:物件の間取りを読み取り

部屋の間取りの画像を与えれば、間取り情報をテキストで回答してくれる。

大量の物件の間取りの画像情報を与えるだけで、ユーザーのニーズによりマッチした物件情報検索サイトを構築できるかもしれない。

GPT4-Vの今後の拡張性

動画のインプットにも対応?

画像を入力情報として処理できるようになったら、次は動画(画像に時系列情報を加えたもの)も対応しようとなるのは自然の流れ。まだこの論文発表時点では動画対応はできていないが、前進として、時系列の少数の画像の入力を元に、次に何が起こるかGPT-4Vに予測してもらう試み(Temporal anticipation)が行われている。

下図の左側では、PKがゴールキーパーによって阻止されるであろうと予測し、右側では画像を元に寿司を作っている場面であることを認識し、次はノリを丸める作業をするだろうと予測している。

入力された動画をフレームごとに切って画像として認識させれば、原理的には動画の解説や次に何が起こるかの予測の回答もできると思うので、あとはPC処理の問題に帰着しそう。なので、来年ごろには動画も対応してそうだ。

論文のsummaryでは、入力モーダルとして動画や音声だけではなく、そのほかのセンサーデータにも対応することが有益であろうと記載されていた。

五感並びに、人間が感知できないセンサー(地磁気や赤外線など)にも今後もしかしたら対応していくのかもしれない。

論文のタイトル「The Dawn of LMMs」というタイトルが良い。

夜は明けた。LMMはこれからだよ。という期待感が。

あと、個人的には、今回の論文でvisual referring promptingに最も衝撃を受けた。画像に対して人間が直感的につける手書きのアノテーションを理解してくれるなんて。

・ダイオード(ツェナー・ショットキーバリア・LED).png)

・ダイオード(ツェナー・ショットキーバリア・LED)-1.png)

コメント