はじめに

米OpenAIは12月20日(現地時間)、新たなAIモデル「o3」を発表した。

複雑な問題解決能力を持ち、科学、数学、コーディングなどの幅広い分野で優れたパフォーマンスを発揮するという。2025年1月末頃に「o3 mini」が、その後「o3」が登場するとのこと。

今回は、GPTシリーズとOシリーズの違いやO3の特徴についてまとめておこうと思う。

Oシリーズとは?

OpenAIが発表した「Oシリーズ」は、従来のGPTモデルとは異なるアプローチである、chain of thought(思考連鎖)でAIの推論能力を強化するモデル群である。このようにすることで、複雑な問題の解決力が大幅に向上している。

従来もGPTシリーズのプロンプトテクニックとして「段階的に考えて正しい解答を出してください」と追記することで、数学など複雑な問題の場合には対応できる可能性があるとされていて、そのハック的なプロンプトが内在的に組み込まれた形である。

GPTシリーズ(GPT-3やGPT-4)は、大量のテキストデータを学習して言語生成や質問応答を行う。しかし、GPTモデルは主に大量のデータと計算リソースをスケールさせることで性能向上を図ってきた。これに対し、Oシリーズは「思考プロセス」を意識した設計が特徴である。

思考連鎖(chain of thought)とは?

chain of thoughtは、AIが複雑な問題を解く際に、人間のように思考のステップを踏む仕組みである。例えば、数学の問題を解く場合、直接答えを出すのではなく、途中の計算過程を経て答えを導き出す。これにより、学習データに存在しない問題にも対応できる可能性が高まる。

従来のGPTモデルでは「3.14と3.9のどちらが大きいか」といった比較が苦手だったが、Oシリーズはchain of thoughtを使って問題を分解し、論理的に解を求めることができる。これがOシリーズの最大の強みである。

なぜ思考のステップを入れるのか?:Scaling Lawに基づく従来アプローチの限界

思考のステップを入れることで計算時間が増えるため、一見非効率に見えるかもしれない。しかし、従来の言語モデルが抱えていた課題として、モデルのスケールアップ(計算リソースやデータの増加)だけでは解決できない問題が存在した。

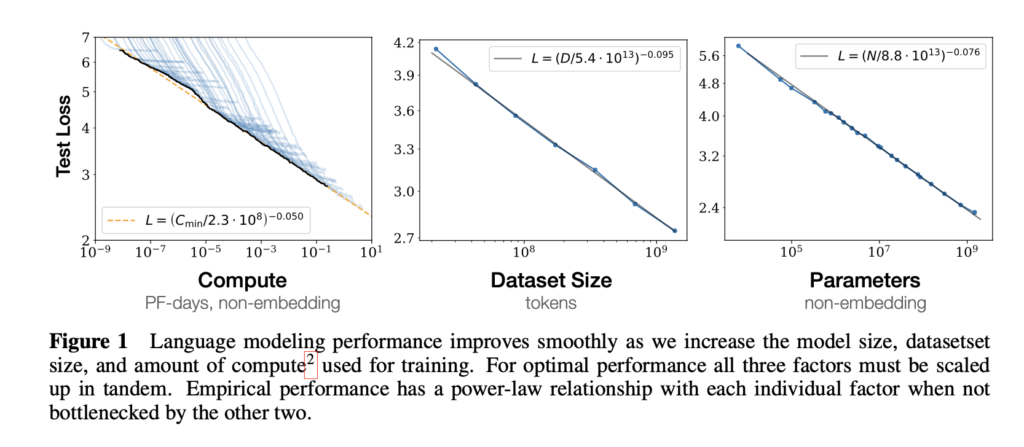

Scaling Law(スケーリング則:AIのモデルを大規模化(スケール)することで性能が向上する関係を表した法則)の研究によると、モデルサイズやデータ量、計算リソースを増やすことで性能は向上するが、その効果は対数スケールで鈍化する。

これにより、モデルのスケールアップがコスト面で非効率になり始める。特に大規模言語モデル(LLM)では、データや計算資源が指数関数的に必要となるため、chain of thoughtのような「質的な改善」が不可欠である。

Scaling Lawの論文はこちら:Scaling Laws for Neural Language Models (arXiv)

O1からO3への進化

O1モデルでは、GPTとは異なる制約で性能が向上することが確認されている。O1は、単純な質問に対して思考過程を経て回答を生成することで、精度が大幅に向上している。GoogleのGeminiなども同様のアプローチを採用している。

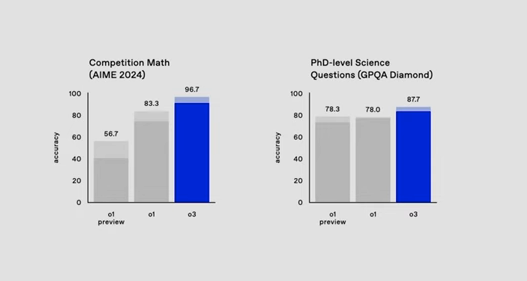

O3はさらに進化し、複雑な数学や推論問題の解決能力が飛躍的に向上している。実際、O3は複雑な数学的推論の問題で25.2%の精度を達成しており、従来のモデルが2%未満であるのに対し圧倒的な差を示している。

競技プログラミングというプログラミングのアルゴリズムを制限時間内に競うテストではグローバルで175位に入るほどになったという。もはやほとんどの人間は叶うことがないレベルになっている。

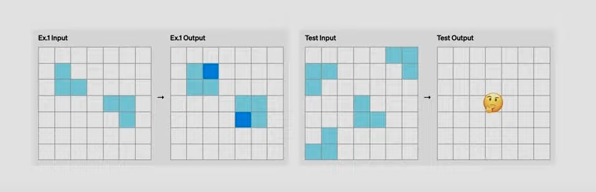

また、人間には簡単に答えられるが、AIには難しかったというパターン認識問題なども、その場で学習し解決できるようになったとのこと。

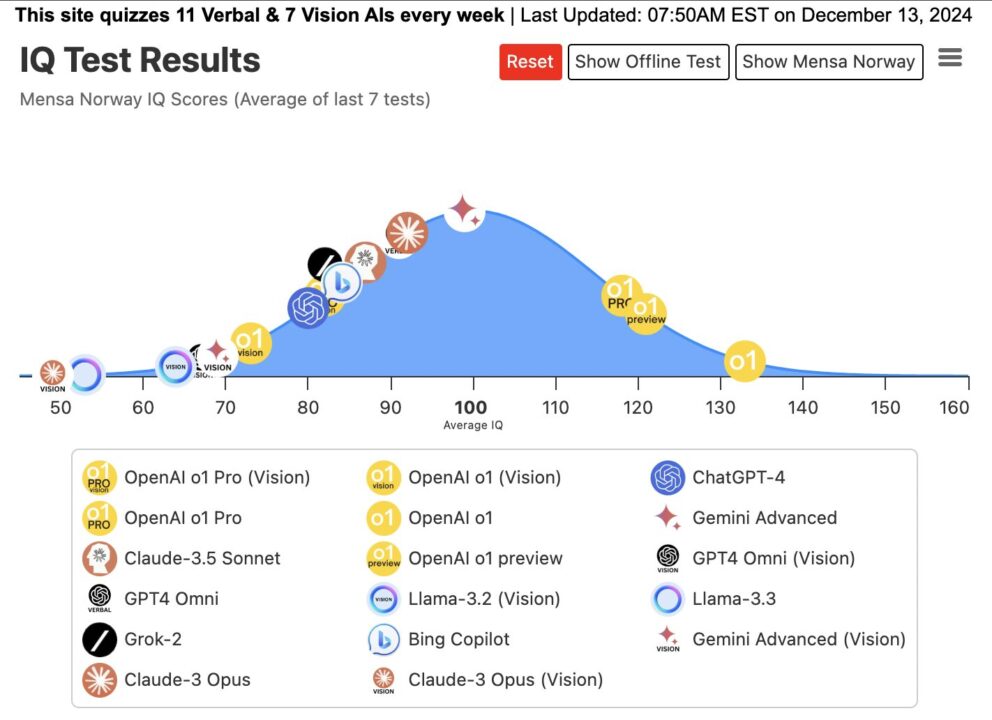

IQテストや、就活でよく出てくるパズル問題などもAIで対応できてしまう。

IQテストは、O1ですでに130を超えてきているのでO3はどうなるんだろう?150超えてくるかもしれない。

AGI(汎用人工知能)にどこまで近づいているかを測るベンチマーク「Ark-AGI」では、人間の平均を超え、最高87.5%となった(o1は最高32%)。

O1をリリースしたばかりなのに、まだここから進化するのかという印象。今後、Chain of Thought以外のアプローチでさらにAIを進化させる手法が見つかれば(研究者が必死にいろんなアプローチを同時進行で探して試していると思うが)、もっと飛躍的に進化するかもしれない。