はじめに

ChatGPT関連の競合のアップデートも凄まじい。ChatGPT, Claude, Gemini間の 機能拡張はよりヒートアップしてきている印象。

ChatGPTのライバルの1つであるAnthropic社が、 昨日Claude 3.5 Sonnetを リリースしたので早速使ってみた。 ちなみに、GPTとGeminiは 使ったことがあるのだがClaudeは初めて。

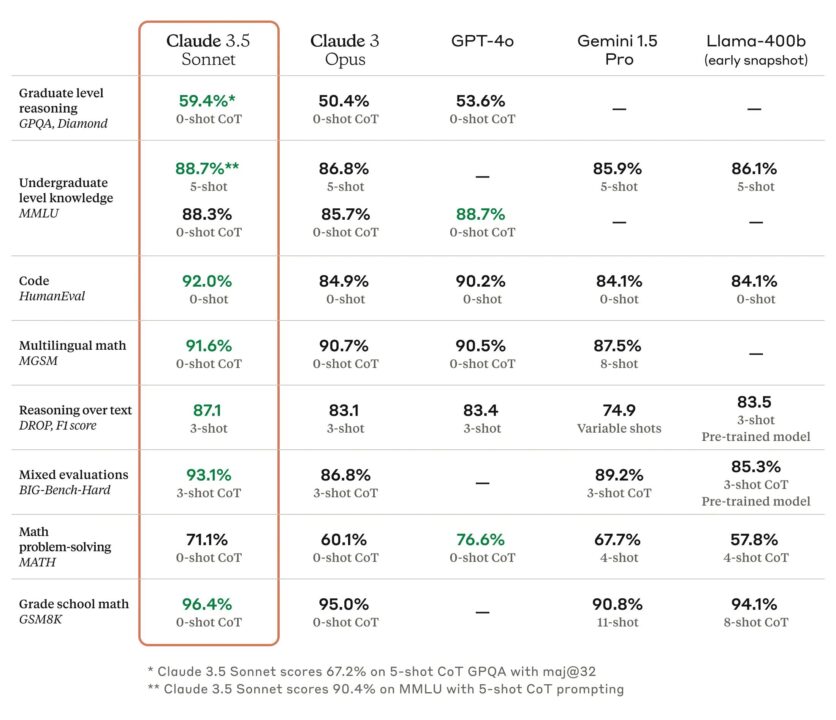

ベンチマーク比較ではGPT4oを上回った?

下記のURLがClaude が発表したリリース記事。記事内の「Try on Claude.ai」をクリックすると、アカウント作成後、すぐにClaudeとのチャット画面に移動できる。

ちなみに自社調べの競合(GPT-4o, Gemini1.5, Llama-400b)との比較では、 ほとんどのベンチマークスコアでGPT4oを上回っているとのこと。 これに関してはベンチマークを出している前提条件をしっかり見ないといけないが(鵜呑みにしてはいけない)。

Claude 3 Opusの2倍の速度で、これまでの5分の1のコストになっている。

入力トークン 100 万個あたり3ドル、出力トークン100 万個あたり15ドルで、トークン コンテキスト ウィンドウは20万個。

今までClaudeは サービスを認識してはいたものの、使ってはいなかったので 使ってみた。

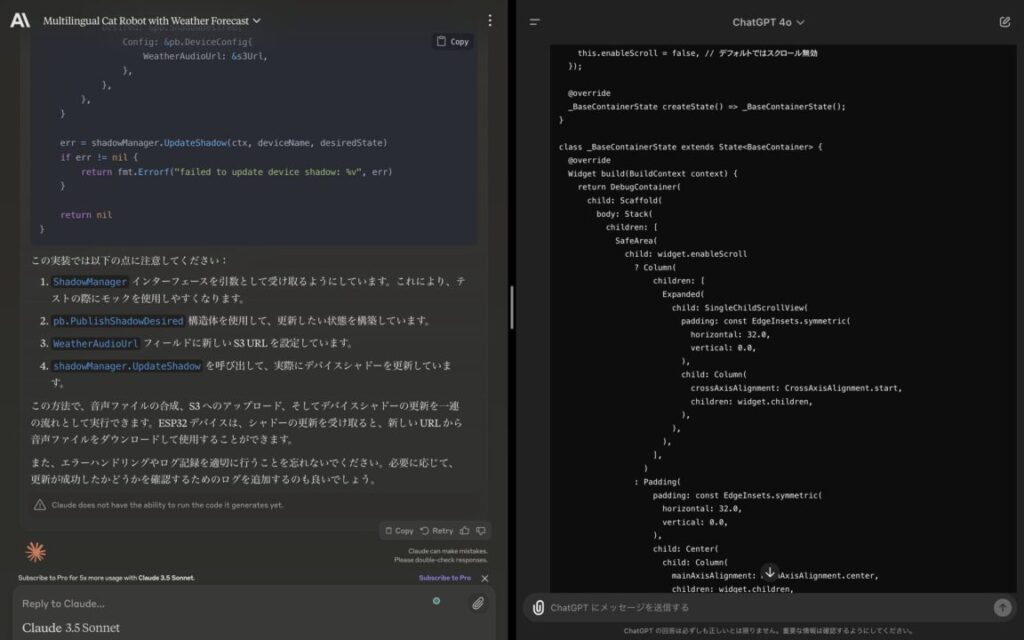

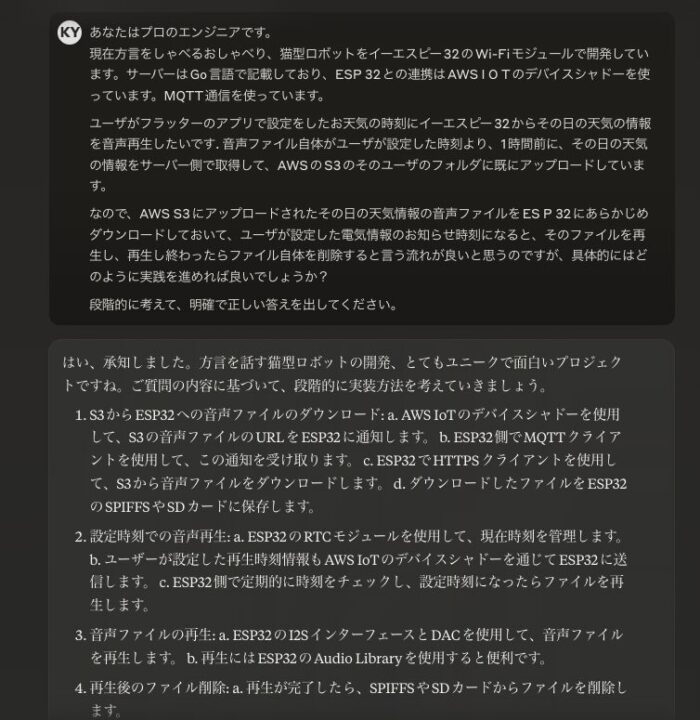

プログラミングの方針を音声入力で指示したところ

自分の場合はGPTはもっぱらプログラミングで使っていることが多いので、今回もプログラミングで使用。

前回こちらの動画で記載した音声入力を使いながらプロンプト指示してみる。

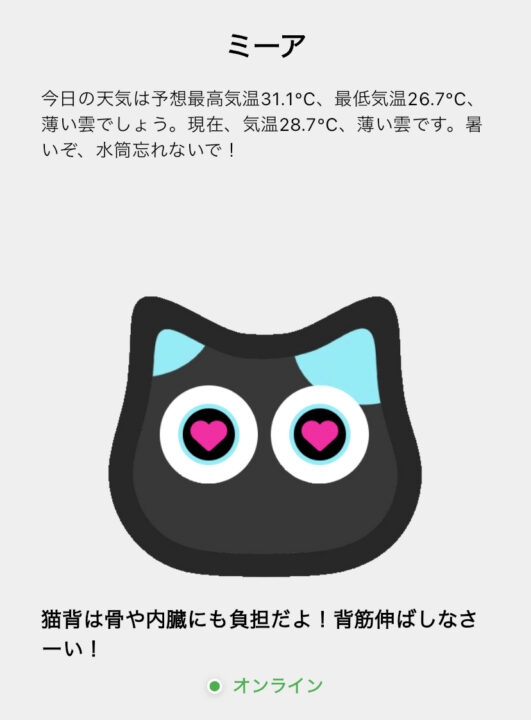

現在、開発中のおしゃべりに小型ロボット「ミーア」でこれから実装する 「その日の天気のお知らせ+アドバイス」を、ユーザがアプリで設定した時刻で、音声で再生するという機能。

アプリの画面では、既にテキストで、その日の天気の情報とアドバイスを表示し、アプリでプッシュ通知しているのだが、 音声再生もあったほうが、「 例えば出勤の際に雨で折り畳み傘を忘れにくくなるだろう」と想定してのこと。

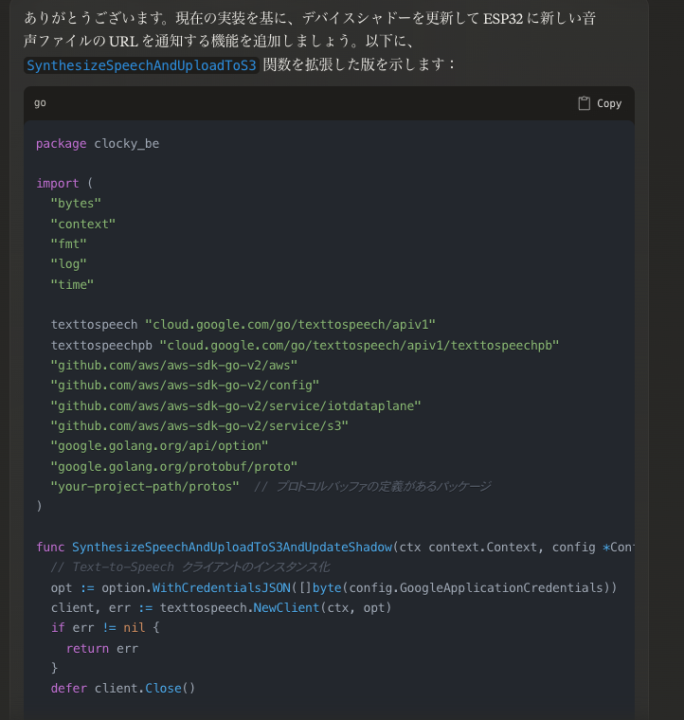

結果はこのようになった。

音声入力で文字起こしに少し誤植があるが(ESP32→イーエスピー32など)、Claude の方でそこは文脈を理解して吸収してくれるので、わざわざ音声入力後にテキストを修正はしていない。

回答入力までのレスポンスも非常に早く、かつ、内容もGPT4oと遜色ないほど良かった。

基本的に自分がプログラミングをするときは、 最初に実装する機能のおおまかな方針をAIに箇条書きで記述させて、 その方針に対して、 既に実装済みの該当となりそうなコードを貼り付けて、 既存の行動に今回の機能を追加するように具体的なコードを記載してくださいという、2段階前で指示をしている。

こちらに関しても特に問題なさそうだった。

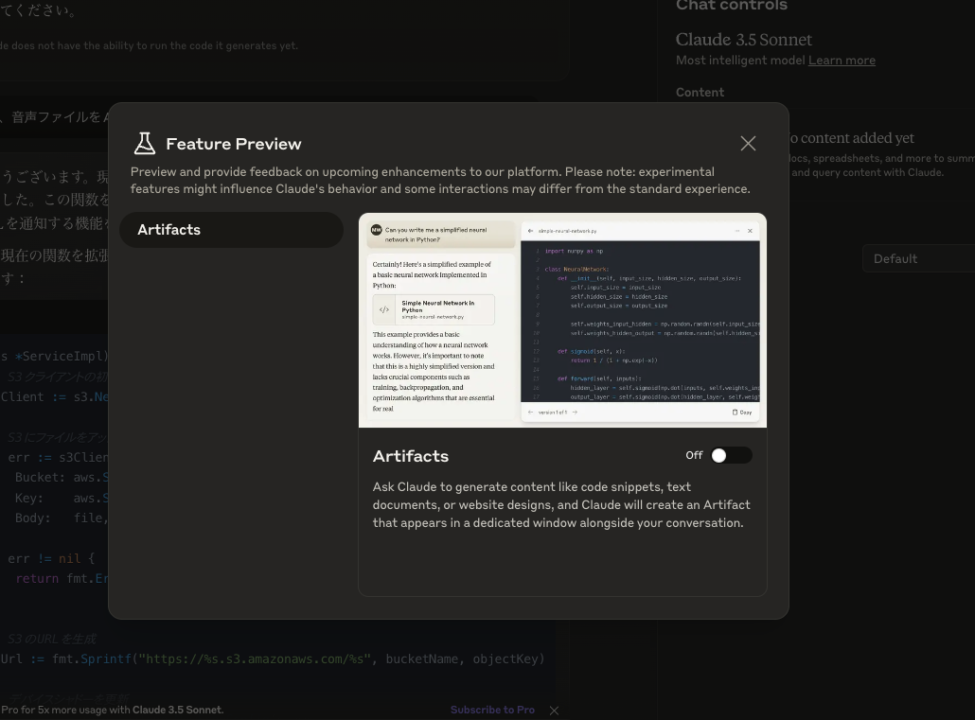

Artifacts機能の使い方:生成コンテンツを分割表示

Artifacts機能は、Claudeが生成したコンテンツを別ウィンドウで表示・編集できる新機能。

- Claude.aiにログイン

- 画面右上のユーザーアイコンをクリック

- ドロップダウンメニューから「Feature preview」を選択

- Artifactsのトグルをオンにする。

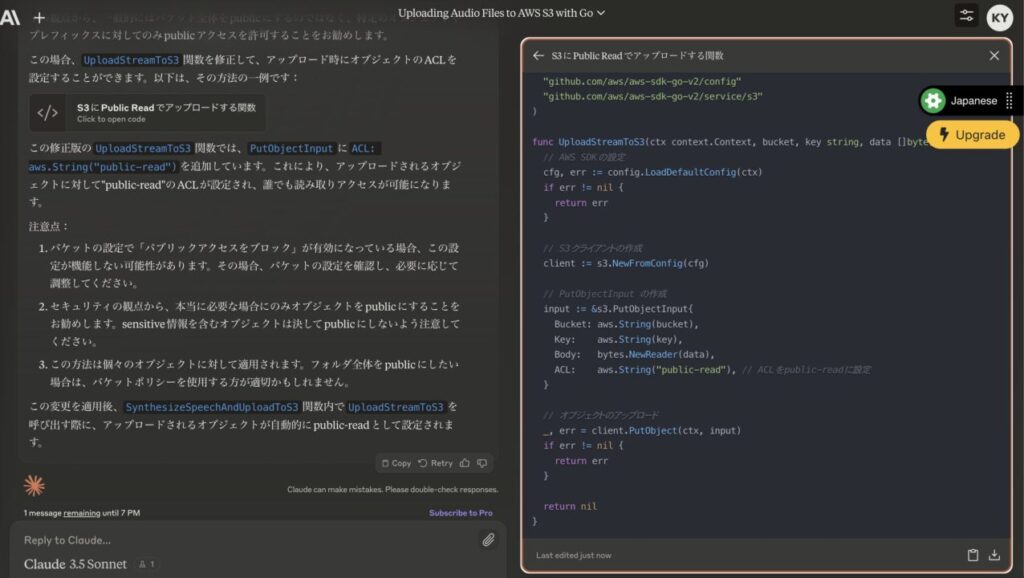

これを利用すると、 自分が入力したプロンプトが左画面に、出力されるプログラミングの効果の結果が右側に分割で表示されるのかなと思ったが、やってみた限りはそうではなさそう。Claude3.5 の方で何を右側に分割表示するかは自動的に決められている感じ。

画面のプレビューなどは右側に表示されるかもしれない。もう少し試してみる必要がある。何回か試していたら、コードだけ右側に表示された。これは見やすくて便利。

しばらく、Calude3.5とGPT4oを下図のように2画面並べてみて、両方試してみようと思う。